es报错:this action would add [2] shards, but this cluster currently has [999]/[1000] maximum normal shards open

一、原因与解决方案

这个是分片不足导致,ES7版本以上,默认的最大分片数是1000, 所以最直接的解决方案就是增大ES的maximum shards。

有2种方法:1是通过kibana开发工具配置,2是通过修改es配置文件。

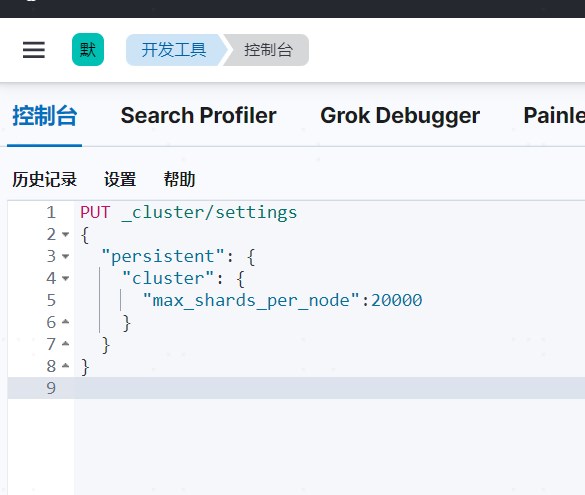

1.通过kibana开发工具修改,如下:

PUT _cluster/settings

{

"persistent": {

"cluster": {

"max_shards_per_node":20000

}

}

}

2. 修改elasticsearch.yml配置,在配置文件中增加以下参数配置:

cluster.max_shards_per_node: 20000

二、延展

1. shard能达到1000,那未来是不是会到达10000,导致出现同样的问题?

为了避免这样的问题再次出现,那就要控制shard的数量,那么shard的数量和什么有关系?

如何控制shard的数量?

首先,回答第一个问题,先要搞清楚,什么是shard?

分片是 Elasticsearch 在集群中分发数据的关键。

把分片想象成数据的容器。文档存储在分片中,然后分片分配到集群中的节点上。当集群扩容或缩小,Elasticsearch 将会自动在节点间迁移分片,以使集群保持平衡。

一个分片(shard)是一个最小级别“工作单元(worker unit)”,它只是保存了索引中所有数据的一部分。

这类似于 MySql 的分库分表,只不过 Mysql 分库分表需要借助第三方组件而 ES 内部自身实现了此功能。

默认情况下,一个索引被分配 5 个主分片

可以看到,分片的数量和索引的数量是成正比的,也就是说索引越多,分片越多;再结合我们ES的实际配置,索引命名方式:环境+日期,环境是固定的,但是日期是每天增加的,那么索引每天都会增加,也就是说分片的数量也会随着时间推移,逐日增加,直到达到最大索引。

所以,针对第一个问题,即使最大分片数是10000,也会出现同样的问题。

2. 那么如何控制shard数量呢?

其实控制shard数量,就是控制索引的数量,控制索引的数量,就是控制保存的log的数量,而log的数量可以通过控制保存的日志有效期天数来决定。

那么,问题转换为:ES如何只保存固定时间段内的日志数据?

有2种方案,一种是通过接口修改,一种是通过ES官网工具curator。

a)

curl -H "Content-Type: application/json" -X POST -d '{"query":{"range":{"@timestamp":{"lt":"now-60d","format":"epoch_millis"}}}}' http://localhost:9200/*/_delete_by_query?conflicts=proceed

# 这里根据默认的时间来作为查询的时 间字段,也可以是自定义的, now-60d保留60天的数据

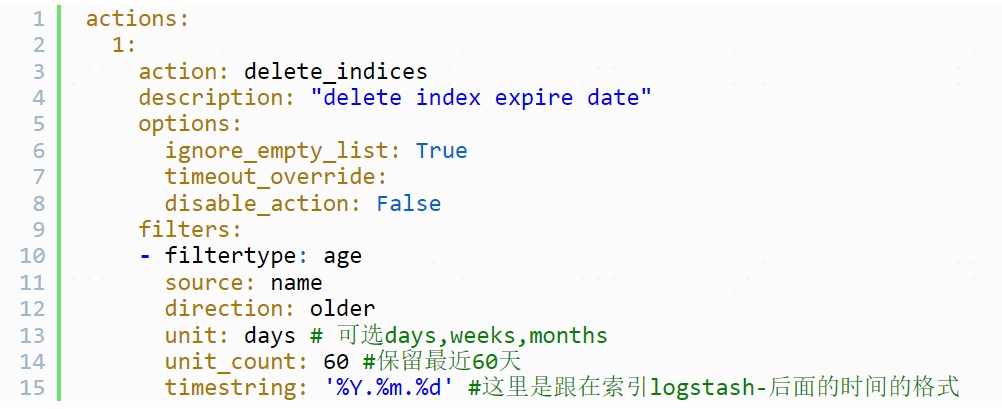

b)通过curator的方案:编写action.yml

actions:

1:

action: delete_indices

description: "delete index expire date"

options:

ignore_empty_list: True

timeout_override:

disable_action: False

filters:

- filtertype: age

source: name

direction: older

unit: days # 可选days,weeks,months

unit_count: 60 #保留最近60天

timestring: '%Y.%m.%d' #这里是跟在索引logstash-后面的时间的格式

共有 0 条评论